ConvAI3의 task에 대한 내용을 다루고 있다.

상대방이 어떠한 말을 했을 때, 그 말에 대한 대답을 하거나, 그 말이 너무 추상적인 경우 더 구체화하기 위한 질문을 하는 task이다.

ConvAI2에 관련된 논문을 읽어보고 궁금해서 ConvAI3을 찾아봤는데, 아직 task에 대한 설명정도만 기술한 것 같다.

원본은 여기에서 볼 수 있고, 관련 홈페이지는 여기에서 확인할 수 있다.

ClariQ는 clarifying question을 하는 dialogue system의 challenge이다. Conversational AI challenge (ConvAI3) 중 Search-oriented Conversational AI(SCAI) EMNLP workshop 2020 에서 진행이 되었다. 이번 대회에서 원하는 conversation system은 질문에 대한 답을 하는 것이다. 이 때, 사용자의 질문은 모호할 수 있고, 모호한 경우 해당 질문을 조금 더 구체화하도록 질문을 하게 된다. (clarifying question) 대회의 구체적인 규칙은 다음과 같다.

- 사용자는 모호한 질문(ambiguoug question)을 한다. 이 질문은 한 개 이상의 정답을 제공할 수 있다.

- 모델을 사용자가 한 질문이 모호한 질문이라는 것을 인지해야 하고, clarifying question을 제공해야 한다.

전체 과정에서 가장 중요한 문제는 다음과 같다.

- 어느 시점에서 clarifying question을 해야하는가?

- 어떻게 clarifying question을 생성할 것인가?

# Challenge 설계

ClariQ Challenge는 총 2 단계로 구성되어 있다.

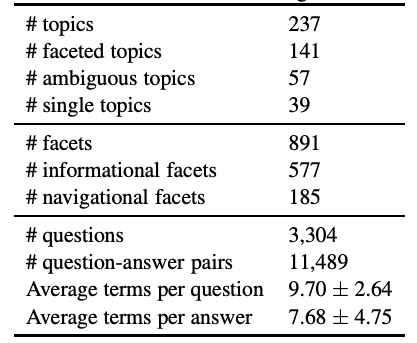

첫 번째 단계에서는 참가자는 static dataset을 제공받는다. 데이터셋은 사용자의 최초 요청(clarification이 얼마나 필요한지에 따라서 1에서 4 사이의 레이블이 주어진다.), clarifying question, 사용자의 응답으로 구성되어 있다. 해당 데이터는 학습(70%), 검증(30%), 테스트 과정에서 사용될 수 있다. 테스트 데이터의 경우, 사용자의 요청과 함께, 응답으로 선택할 수 있는 질문들(clarifying question)의 목록이 제공된다. Crowdsourcing을 통해서 새로운 데이터셋을 구축했다. 데이터셋의 통계는 [표-1]과 같다. Automatic evaluation 방식으로는 MRR, P@[1,3,5,10,20], nDCG@[1,3,5,20] 을 사용한다. 전체 데이터셋과 평가 과정의 스크립트는 해당 GitHub에 업로드되어 있다.

두 번째 단계에서는 사람이 과정에 참여하게 된다. 실제 사용자에게 결과가 제공되어 TOP-N 개의 모델을 선정하게 된다. 각 대화 단계에서 모델은 사용자의 요청에 대한 정확한 대답을 제공하거나, clarifying question을 제공해야 한다. 그러므로 참가자들은 다음과 같은 조건들을 만족하는지 확인해야 한다.

- 모델이 단순한 질문을 대답할 수 있어야 한다.

- clarification을 언제 해야 하는지 모델이 직접 판단할 수 있어야 한다.

- 적당한 시점에서 claifying question을 제공할 수 있어야 한다.

- 제공한 clarifying question에 대해서 사용자의 대답을 이해할 수 있어야한다.

모델을은 너무 많은 질문을 하는 것과 관련 없는 응답을 하는 상황도 고려해야 한다. 해당 과정은 generative model에 대해서 수행할 수 있다.

# 평가 방식

실제 사용자와의 의사소통의 결과로 (여태까지 대화 내용, 모델의 응답, 응답에 대한 점수) 를 결과로 구축한다. 추가적으로 전반적인 대화의 퀄리티도 점수로 반영한다. 이 때, relevance (사용자가 원하는 정보와 관련이 있는 응답을 제공했는지)와 naturalness (현재 대화 문맥과 관련이 있는 응답들을 제공하는지)를 고려한다. 또한 [그림-1]과 같이 사용자가 yes/no 로 대답할 수 있는 상황은 피하도록 한다.

# 관련 논문

What do you mean exactly? analyzing clarification questions in cqa. : clarifying questions (1)

Learning to ask good questions: Ranking clarification questions using neural expected value of perfect information. ; clarifying questions (2)

Leading conversational search by suggesting useful questions. : clarifying questions with information retrieval (1)

Asking clarifying questions in open-domain information-seeking conversations. : clarifying questions with information retrieval (2)

Generating clarifying questions for information retrieval. : clarifying questions with information retrieval (3)

Mimics: A large-scale data collection for search clarification. : MIMICS dataset

Natural questions: a benchmark for question answering research. : Q&A domain (1)

Identifying unclear questions in community question answering websites. : Q&A domain (2)

댓글